Scraper es un sitio web que copia todo su contenido de otros sitios, utilizando para ello diferentes métodos automatizados. En los últimos años, con la aparición de Google Adsense, los sitios Scrapers han proliferado como un hongo en invernadero, tanto así que los editores de contenido original se sienten incómodos por ello y los buscadores se están preocupando cada vez más, por identificar correctamente a cual sitio le pertenece tal contenido.

Con el crecimiento del contenido duplicado, los buscadores se ven obligados a aplicar formulas que les permitan identificar la fuente original, premiarla colocándola en buenas posiciones, y penalizando al sitio que duplica contenidos con fines poco éticos.

Un buscador que como resultado devuelva distintas webs con el mismo contenido, tendría un serio problema de calidad.

En ese sentido, Google acaba de publicar un post tocando el tema del contenido duplicado, de los Scrapers y de sitios, que sin ser Scrapers, también duplican contenido. Tema que no es nuevo, y que ha estado en el tapete del mundo SEO desde hace varios años, pero que actualmente se ha incrementado de manera notoria (sobre todo en nuestro idioma).

Sólo hace falta realizar algunas búsquedas para comprobar que la eficacia de los buscadores aún no es la esperada. Muchas veces los agregadores, planets o redes sociales, en el ejemplo Menéame, suelen estar mejor posicionados que la página a la que referencian. O un blog popular que referencia un contenido, suele ubicarse en mejor posición que el sitio original.

Así pues, en este artículo vamos a ver varios tips SEO dados por el blog oficial de Google y por Vanessa Fox, en su blog personal, entre otros...

Dos escenarios respecto al contenido duplicado

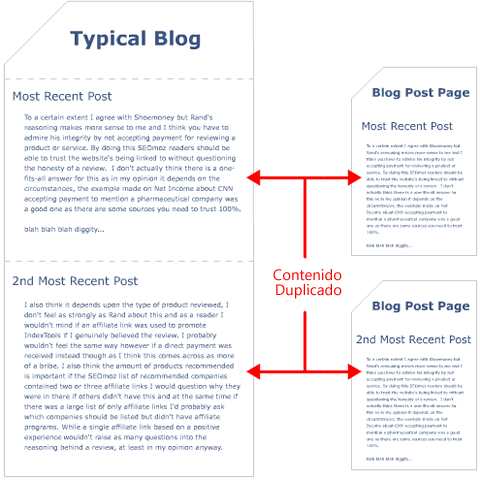

Contenido duplicado en nuestro propio dominio; es decir, contenido idéntico (a menudo involuntariamente) que aparece en más de una página de nuestro sitio.

Contenido duplicado en otro dominio; es decir, contenido idéntico de nuestro sitio web que aparece (puede que también, involuntariamente) en diferentes sitios externos.

En el primer escenario, podemos coger al toro por los cuernos, y evitar la indexación de contenido duplicado en nuestro propio sitio.

Así podemos:

- Utilizar el fichero robots.txt para impedir la indexación de páginas con contenido duplicado.

- Utilizar redirecciones 301 cuando reestructuremos nuestro site

- Ser consistentes a la hora de enlazar nuestras páginas internas. Por ejemplo, no hay que enlazar a /pagina/ y /pagina y /pagina/index.htm.

- Hay que tener cuidado con la sindicación del contenido, incluyendo enlaces al contenido original.

- Hay que utilizar un tipo de dominio siempre, ya sea con o sin WWW.

- Hay que tener cuidado con nuestro CMS, y conocer cómo es que muestra nuestro contenido, sus sistema de paginación, las páginas de etiquetas, etc.

- Hay que utilizar el archivo sitemap, ya que ayuda a Google a determinar cual versión de su URL es la del contenido.

En el segundo escenario, en el que han copiado nuestro contenido, muchas veces para obtener un beneficio económico, hay que darle a Google ciertas señales que le permitan determinar cuál es el sitio original.

En la mayoría de los casos, lo primero que hay que asegurarnos, es que el contenido duplicado tenga un enlace a la fuente original. Sobre el tema, Vanessa Fox comentó algunos tips a tener en cuenta.

¿Cómo asegurar que nuestro sitio posicione primero?

Hay muchas razones por las cuales ofrecer la sindicación de contenido es buena. Posibilitar la suscripción por feeds, por emails, fidelizar lectores, participar en planets, redes sociales, etc. Oportunidades todas, de incrementar la exposición de nuestro sitio/blog a una mayor audiencia.

Ahora bien, si nosotros ofrecemos sindicar nuestro contenido pero queremos que nuestra versión, la original, sea mejor ubicada en los buscadores que el resto, debemos:

- Crear una versión diferente del contenido a sindicar respecto de la publicada en el propio sitio. Este método sería el ideal, aunque no suene muy bien si nuestro sitio es un blog. En este caso, podríamos ofrecer un sumario o resumen del artículo en la sindicación y el artículo completo en la página alojada en nuestro sitio.

- Siempre hay que incluir en el cuerpo del artículo, enlaces absolutos a nuestro propio sitio. Esto es particularmente útil cuando nuestro contenido es copiado por Scrapers.

- Si nuestra intención es compartir nuestro contenido, llámese en un planet. Podemos solicitarle al editor del planet que bloquee el acceso a los artículos (utilizando el fichero robots.txt o meta tags). De esta manera, ambos sitios ganan. Y con ello, podemos determinar si un sitio es verdaderamente un planet o un simple scraper.

¿Me han copiado el contenido y su sitio aparece primero en Google?

Con lo dicho anteriormente, Google asegura, casi al 100%, que son capaces de determinar a que sitio pertenece tal contenido. Sin embargo, hay casos adversos. Hay veces en que el contenido duplicado suele aparecer en una posición superior a la fuente original. En estos casos, Google pide lo siguiente:

- Comprobar si el contenido original es accesible a los buscadores. Es posible que se haya bloqueado su acceso en el archivo robots.txt

- Observar si en el archivo sitemap se han hecho cambios respecto al contenido duplicado

- Comprobar si el sitio cumple las directrices para webmasters de Google

Consideraciones finales

Finalmente, hay que mencionar que el contenido duplicado es causa de penalización. Obviamente, siempre que se realice con mala intención, en los casos del primer escenario por ejemplo, Google simplemente los filtra.

Asimismo, últimamente Google está haciendo mucho caso al feedback de los usuarios. Actualmente, están publicando una serie de artículos referente a ello y la importancia que tiene para identificar sitios spam, made for adsense, backdoors, etc.

Por lo que si somos víctimas de Scrapers, y su sitio posiciona mejor que el nuestro, siempre podemos enviar un feedback explicando motivadamente nuestra situación.

Lectura recomendada: Checklist para el posicionamiento en buscadores.

acabo de ver un articulo parecido en adseok pero veo que lo que presentas esta mucho mas elaborado, para comentar yo vi un script en php que copiaba las noticias de un feed y mediante un echo las imprimia en otra pagina. esta es una de las tantas formas de scrapers

http://www.adseok.com/tips-seo/google-sobre-el-contenido-duplicado-de-sc...

La mayoría de scrapers utilizan ese método.

Habia oido del clasico "Copy" y "Paste" en la comunidad de los blogs, o el defecto de algunos adjudicarse los articulos de otra fuente y firmar su autoria quitando el credito a otra persona, pero esto es peor de lo que imagine, considero poco profesional principalmente cuando lo unico que desean es aparecer entre los primeros al momento de la busqueda de información.

Enhorabuena por el artículo, muy bien elaborado y completo.

El cuarto punto en el que se determina por la fecha de indexación cual es el original pasa muchas veces que hay sitios que por lo que sea indexan más rápidamente y por tanto el original queda relegado.

En definitiva, Google tendrá que afinar mucho más sus algoritmos.

buen artículo, directo a mis marcadores ;)

Sin embargo me queda la siguiente duda: en nuestra web ingresa contenido diario provenientes de otros sitios. Éstos son publicados mencionando a sus respectivas fuentes y agregando un enlace limpio hacia la misma sin excepciones. Por supuesto es un artículo por página. La razón es porque intentamos filtrar y reunir en un solo sitio todas las noticias concernientes a nuestra temática. Quisiera saber si esta acción perjudica el posicionamiento de la web, o si por el contrario el robot "toma en cuenta" que se ha colocado un enlace hacia el artículo original. Gracias.

Muy buen post, lo leí hace años y me sirvió de bastante. Actualmente con Google Penguin todo es más difícil para los scrapers.

http://communitymanager.in/index.php/tag/google-penguin/